2023-10-04 08:46:48 发布人:hao333 阅读( 5623)

在最近MIT科技评论的专访中,DeepMind联创,Inlfection AI创始人表示,他们已经将AI毒性去除,生成式AI只是过渡,未来AI将获得像人一样的自...

在最近MIT科技评论的专访中,DeepMind联创,Inlfection AI创始人表示,他们已经将AI毒性去除,生成式AI只是过渡,未来AI将获得像人一样的自由。

DeepMind的联合创始人,Inflection AI的创始人,Mustafa Suleyman接受了MIT科技评论对他进行了一次线上专访,在专访中,他抛出观点:

现阶段的生成式AI只是一个技术阶段,接下来会进入交互式AI的时代:AI将会成为能够根据每个用户的不同任务需求去调用其他软件和人来完成工作的机器人。

他创办的公司——Inflection AI的目标,不仅仅是一个聊天助手,而是想要通过AI让世界上的绝大多数人获得更加平等的资源和信息。

最后,他还呼吁政府要积极的对AI进行监管,并认为将AI在现有制度下进行监管不难实现。

也许与Suleyman有相似看法的人并不少,但与大多数人不同的是,是一个估值数十亿美元的公司——Inflection AI的领导者。

这个公司拥有来自DeepMind、Meta和OpenAI的顶级人才,并且通过与英伟达的合作拥有全球最大的专业AI硬件算力储备。

我们正处于AI技术的三波浪潮中的第二波

在Sulyman看来,第一波AI浪潮是关于分类的。深度学习表明,人类可以训练计算机对各种类型的输入数据进行分类:图像、视频、音频、语言。

现在处于第二波浪潮,生成式AI之中,输入数据并生成新数据。

第三波浪潮将是交互式AI。他一直认为对话是未来的交互界面。用户不仅仅是点击按钮和键入文字,用户会与AI进行直接的对话。

这些AI将能够自主采取行动。只需要给它一个一般性的、终局的目标,AI将使用所有工具来实现这个目标。

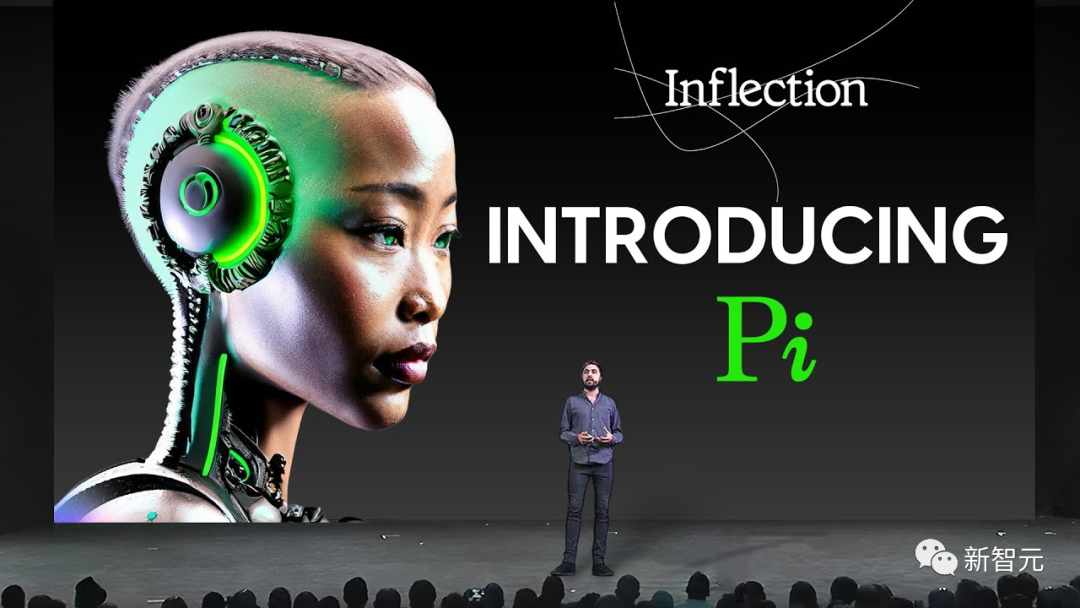

它们会与其他人对话,与其他AI对话。这就是他将要用Pi来实现的东西。

这是技术能力的巨大升级。这是技术史上一个影响非常、非常深远的时刻,他认为许多人都低估了技术的潜力。

AI技术现在依然还是静态的。它基本上是按照你告诉它的方式去做事。

但技术将变得有生命力。如果用户给予AI充分的自由,AI就能去利用这种自由去采取行动。

这确实是人类历史上一个质的飞跃,我们正在创建具有这种智能体能力的工具。

人类将始终是主导者。人类需要确定AI不能越过边界的限制,并确保这些边界从实际代码到与其他AI或人类的互动,再到创造技术的公司的动机和激励,都能提供可证明的安全性。

早年经历对自己价值观和创业的影响

当被问到他与众不同的职业经历和传统的「硅谷风」截然不同,而这些经历对于他在硅谷创业有什么影响时,Suleyma回答到:

他一直对权力、政治等方面很感兴趣。他觉得人类基本原则是妥协的产物。依靠的是不同的、相互冲突的力量之间持续不断的协商才能达成的一种动态平衡。

虽然人类在不断地解决问题——但是人类依然会被自身的偏见和认知盲区所限制。

民间组织、地方政府、中央政府、国际组织等等——都会受到自身的限制而没有办法高效的,不犯错的运作。

想象一下,如果人类不会犯错误,将会出现什么情况?

他觉得人类有可能构建出真正反映自身利益的AI,并最终更一致、更公平地代表所有人做出更好的利弊权衡。

Suleyma说,离开DeepMind后,他已经财务自由了。不需要去创业或者写书赚钱来养活自己。

钱从来都不是工作的动力。钱是工作的副产品。

对他来说,工作的目标从来没有变过,就是如何让世界变得更好,以及如何以一种健康、令人满意的方式推动世界前进。

即使在2009年那时,当他开始考虑进入科技行业时,他就看到了AI技术代表了一种在世界上提供服务的公平和准确的方式。

如何看待技术的负面影响

他认为过于纠结于谁是乐观主义还是悲观主义没有太大的意义。这是有偏见的看待事物的方式。他只想冷静地分析利益和挑战。

站在他的立场上,可以非常清晰地看到,随着大型语言模型规模的进一步提升,它们变得更易控制。

所以两年前,当时的观点——他当时就认为是错误的——是「哦,它们只会产生有毒的、反刍的、有偏见的、种族主义的内容。」

但是这些情况都只是暂时的。人们忽视了技术不断地进展,没有真正理解技术向前发展的轨迹。

现在Pi这样的模型,非常的可控。Inflection AI 可以不让Pi产生种族主义、同性恋歧视、性别歧视——任何形式的有毒内容。

能让它拒绝教用户制造生物或化学武器,或者鼓励用户去砸邻居的窗户。

至于如何实现,Suleyma不想透露过多的技术细节,但是他说,请放心大胆地去实验!Pi已经上线了,用户可以尝试所有可能的攻击方式。

针对Pi的任何越狱、提示黑客攻击或任何事情都不起作用。这就是一个客观事实。

Inflection AI有世界上最强大的团队,在过去三四年里创造了所有最大的语言模型。

这是一个非常出色的团队,在一个非常高效的环境中工作,拥有大量的计算资源。

他们一开始就把安全作为第一优先事项,因此,Pi没有像其他公司的模型那样那么「火辣」。

看看Character.ai。 它的功能主要用来创造天马行空的角色,但是Inflection AI一开始就觉得这不是一个好的方向——他们不会做这样的功能。

Pi会非常尊重你。如果你开始抱怨你社区的移民抢了你的工作,Pi不会指责你,不会对你指手画脚。

Pi会关心地询问并给你提供语言和心理上的支持。它会试图了解用户这种情绪从何而来,并温和地鼓励你去同情别人。这些都是我思考了20年的价值观。

但被问到如果开源这些技术能让世界变得更好的话,为什么不开源。

Sulyman强调,自己毕竟在经营公司,得挣钱养活大家,之前买了英伟达13亿的GPU,得赚钱满足投资者对回报的要求。

现在开源生态系统正在蓬勃发展,做得相当不错,开源社区也发现类似的方法。Suleyman只假设他们最多领先六个月。

AI监管如何有效进行

对他而言,开发AI递归自我改进的技术需要被监管起来,小型AI在没有你的监督下去更新自己的代码是危险的,也许这甚至应该是一个需要许可的行为。

或许需要像处理炭疽或核材料一样,有专门的机制来监管这种行为。

他还认为,对于AI的恐惧是完全没有必要的。AI监管完全可以落脚在现在的监管框架之内。AI只是治理体系的另一个组成部分。

人类在规范超复杂事物方面做得非常出色。联邦航空管理局为例:我们都已经习惯乘坐这些铝制管道在四万英尺的高空飞行,而这是有史以来最安全的交通方式之一。这就是监管成功的例子。

或者汽车:每一个组件都经受了极限的压力测试,而用户必须有驾照才能驾驶它。

有些行业——比如航空公司——一开始就很好地自我规制。因为他们知道,如果他们没有做好安全工作,大家都会害怕,他们就会失去生意。

相关阅读

RelatedReading猜你喜欢

Guessyoulike