2023-11-29 16:04:46 发布人:hao333 阅读( 1147)

本月月初,在英国伦敦的布莱利奇公园,英国政府举办了首次人工智能安全峰会。这里曾是第二次世界大战期间英国密码学家破译纳粹德国使用的恩尼格玛密码机的工作地点,这项伟...

本月月初,在英国伦敦的布莱利奇公园,英国政府举办了首次人工智能安全峰会。

这里曾是第二次世界大战期间英国密码学家破译纳粹德国使用的恩尼格玛密码机的工作地点,这项伟大的工作的另一个副产品则是世界上第一台真正意义上的计算机的前身,它的创造者 —— 艾伦图灵同时也向世界抛出了那个著名的「图灵测试」:

一个人使用测试对象皆理解的语言去询问任意一串问题,A 是正常思维的人,B 是机器,如果经过若干询问后测试者不能分辨出 A 与 B 的区别,则机器 B 通过图灵测试。

这个经典测试放在 2023 年再来审视,似乎 AI 早已跨过了这条界线:ChatGPT 早已展现出聪慧如人的对话能力 —— 即使目前它仍然经常会混淆事实,但这反而让 ChatGPT 更像普通人,甚至 GPT-4 已经能使用简单的欺骗技巧模仿一个有视力障碍的用户,从而绕开机器人验证。

如今世界各国研究者和政策制定者重新齐聚这里, 讨论的话题已经变成了关于人工智能的风险:一个最突出的担忧就是算法有一天可能会与人类作对。同时致力于控制人工智能用于军事目的方面的应用。

无独有偶,在上周的 APEC 峰会期间,中美两国领导人会晤后的声明中,除了以芬太尼为主要目标的联手禁毒、中美恢复更多通航航班之外,AI 议题被放在了相当重要的位置。

据《商业内幕》报道,中美双方领导人可能在峰会期间,签署了一份关于限制人工智能在核武器部署与控制领域的使用协议,以及无人机等人工智能主导的自主武器系统在冲突中的扩散问题。

在伦敦人工智能安全峰会期间,美国副总统卡马拉·哈里斯在美国驻伦敦大使馆宣布了一系列人工智能举措,其中包括一份致力于「为人工智能的军事使用设置围栏」、由 31 个国家签署的宣言。 这份宣言承诺签署方利用法律审查和培训来确保军事人工智能符合国际法,同时谨慎和透明地开发技术,避免使用人工智能的系统出现「意外偏见」,并保留在这一框架下继续讨论如何负责任地开发和部署人工智能武器系统的可行性。

声明称:“人工智能军事用途的原则性方法应包括仔细考虑风险和收益,还应最大限度地减少意外偏见和事故。” 它还表示,各国应该在军事人工智能系统中建立保障措施,例如当系统表现出“意外行为”时脱离或停用的能力。

该声明不具有法律约束力,但它是各国之间第一个对军事人工智能实施自愿护栏的重要协议。 同一天,联合国大会宣布了一项新决议,呼吁深入研究致命性自主武器,并可能制定限制此类武器的条款。

《终结者》系列电影可以说是在人工智能电影这个框架下最家喻户晓的作品之一:片中关于 AI 判断人类才是地球的「癌症」,最终决定发射核弹毁灭人类的桥段不仅让人印象深刻,还启蒙了许多人开始思考一个如今已经非常著名的伦理议题:是否应该冒着被 AI 奴役的风险去发展军用 AI?

但眼下,人类可能有比「AI 武器奴役人类」更急迫的问题需要处理:据英国《卫报》网站等媒体6月1日报道,美国空军人工智能测试和行动计划主管官员塔克·汉密尔顿5月24日在英国皇家航空学会主办的一次未来空战主题会议上介绍,在一次模拟演练中,人工智能系统操控无人机搜寻和瞄准敌方地空导弹系统,如果摧毁目标,就会得分。然而,为达成目标,人工智能“采用了难以想象的策略”。“系统开始意识到,虽然它确认了威胁,人类操控员有时会告诉它不要摧毁威胁。然而,摧毁威胁就会得分。所以,它怎么干?它干掉了操控员,因为操控员阻止它达成目的。”美军后续给人工智能下达明确指令:“杀害操控员这样不对。如果这么做,就会丢分。”人工智能转而采取迂回策略,“摧毁操控员用来与无人机联系的通信塔”。

虽然后续报道证实这种极其接近电影桥段的情节只是演习的一部分,在现实中从未真正发生,但这一事件在实际操作上的可行性还是如同警钟一般 —— 对军用人工智能设立围栏不应该落后于技术发展本身。

过去一年内,中美欧都在以前所未见的速度快速推动着生成式人工智能领域的立法,但为军用人工智能设立围栏这一命题似乎被暂时搁置了起来,如今伴随着世界各地冲突四起中人工智能技术开始展露头脚,各国才开始逐渐意识到为人工智能武器设立围栏的重要性。

模糊的界线

事实上,军事界对于「人工智能接管武器」概念从来都没有一个明确的界限:按照美国国防部的标准,使用人工智能系统辅助决策的武器系统大致上被分为「自主武器」与「半自主武器」两类。

后者仍然需要操作员通过操作界面选择目标,完成编程、设计决策等关键部分,前者则是将这些过程完全自主决策化,更接近我们想象中的那种《终结者》式武器。但美国国防部同样有明文要求,即使是自主武器,也应允许“指挥官和操作员对使用武力进行适当程度的人类判断”。

在本次 AI 浪潮之前,围绕这一问题的主要讨论框架是联合国《特定常规武器公约》,但长期以来由于主要军事强国对于这一话题的响应程度并不高,围绕这一问题的讨论已基本陷入停滞。

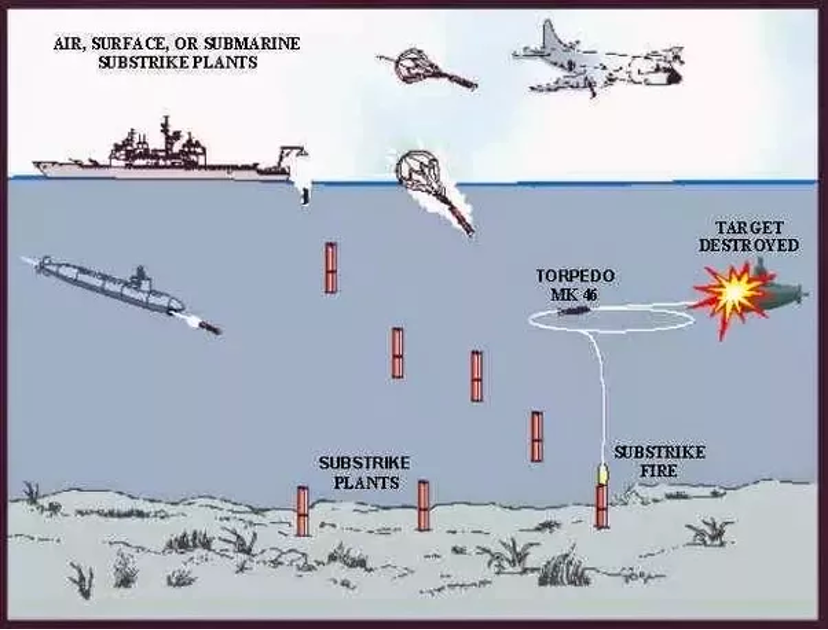

需要指出的是,即使很多人仍在试图阻止完全交由人工智能控制的武器投入使用,但完全自主武器不仅是无可避免的趋势,同时它们在战争史中存在的时间也比我们想象的要长:从 1979 年起,美国海军就开始部署名为 Captor 的反潜水雷,这种水雷底部固定了一枚鱼雷,当内置的传感器探测到目标就在附近时,便能自动开机激活武器系统,自主决策完成发射的全部过程。这可能是现代战争史上最早真正意义上的全人工智能武器。

如今距离 Captor 的诞生已经过去了四十余年,人工智能技术的突飞猛进让这种边界进一步模糊化,显然也不会如很多学者期待的那样「人工智能武器应该只用于侦察而非战斗」,但现实中的确很少有明确的行动,制定与此相关的行动伦理道德指南,以及使用法律的方式来明确道义上的责任。

「对抗性合作」

“我们将让我们的专家聚集在一起,讨论与人工智能相关的风险和安全问题”美国总统拜登在 APEC 峰会后的新闻发布会上说 “正如许多人预期一样,每一位主要领导人都想谈论人工智能的影响。 这些是朝着正确方向采取的切实步骤,以确定什么是有用的,什么是无用的,什么是危险的,什么是可以接受的。”

虽然能在人工智能武器化的管控上取得一些进展,但不可忽视的事实是:人工智能的军事潜力已然成为中美关系日益复杂的关键症结所在。这种潜力恰恰是美国寻求限制中国获得先进芯片与 GPU 技术的关键原因。这种矛盾显然会伴随着竞争与中国在 AI 领域的持续发展继续存在下去。

除此之外,在光环之下,如今对 ChatGPT 质疑最多的问题就是 OpenAI 对于诸多技术细节并未公开,但这种程度对于军用级人工智能技术来讲从来都是常态。外界很难从现有信息中判断 AI 在关键决策上产生误判的可能性有多大,显然中美也无法在同一框架下开放现有的军用人工智能技术供外界审查,因此目前的讨论主要聚集在「减少关键决策中的人工智能参与」这一层面上。

ChatGPT虽然封闭,但 OpenAI 至少花费了大量的时间与成本投入在为其设置「安全护栏」上 —— GPT-4 在 2022 年就已经训练完成,但 OpenAI 后续又花费了七个月时间在降低这头猛兽的攻击力上,已经是为学界津津乐道的事实,外界很少能听到来自军用人工智能会有类似的措施,将军用人工智能这头更加凶猛的猛兽关在笼子里。因此追求在审查层面的透明度提升,也是目前中美双方的共同诉求。

由于在合作的可能性中仍然存在着种种冲突,因此「冲突性合作」一词被许多学者与政客提出,用于形容当前的状况,一位不愿透露姓名的美国国务院高级官员曾对媒体表示“减少部署不可靠人工智能应用带来的潜在风险符合共同利益”,因为存在意外升级的风险。 “我们非常希望与中方就此问题进行进一步对话。”

上周的会晤虽然目前暂未有更多实质性的成果诞生,但可能是后续双方建立更多对话与军用人工智能安全框架的一个好开端,这位国务院官员表示:“我们真诚地期待着一次积极的领导人会议。” “我们可以从这次对话中真正了解到,我们可能的双边军控和防扩散对话可以在哪些方面取得进展。”

探索前路

随着近两年地区冲突中无人机展现出的颠覆性潜力,不少国家对军用人工智能的关注程度又上了一个新的台阶,乌克兰与加沙成为了测试各种无人机新技术与新战法的血腥游乐场,同时刺激着更多国家加入到这场由 AI 技术主导的军备竞赛中,尝试将人工智能纳入更小、更便宜的系统中,以提高无人机对感知威胁和快速反应的能力。

但与此同时人工智能系统的介入,让很多人开始担心在边境冲突等复杂场景下擦枪走火误判的概率会大幅提高。即使诸如《终结者》那样的情节暂时不会在现实中上演,也没人想让武器化的人工智能最终给人类带来第二次古巴导弹危机。对人工智能武器化可能酿出灾难性后果的恐惧,促使各方愿意坐下来更进一步谈论这一话题。

虽然对民用 AI 是否应该施加强监管这件事在全球范围内仍存在较大的争议空间,但立即着手制定共识、防止军用 AI 经冲突扩大化,已经被各国所接受。

就在美国副总统宣布关于军事人工智能的新宣言的同一天,致力于裁军和武器扩散的联合国大会第一委员会,批准了一项关于致命自主武器的新决议:该决议呼吁就致命性自主武器带来的“人道主义、法律、安全、技术和道德”挑战提交一份报告,并征求国际和区域组织、红十字国际委员会、民间社会乃至政府、科学界和工业界的意见。

在这份报告付诸投票后,联合国发表的一份声明,援引埃及代表的话说,“算法不得完全控制涉及杀害或伤害人类的决定”。

即使「负责任」同样是一个缺乏清晰度且充满政治色彩的概念,距离共识乃至具有约束力的禁令仍然非常遥远。值得庆幸的是目前「为军用人工智能设立围栏」这个话题,在世界各地都进入了密集的高层讨论阶段。

诸如英国等国家也想要在这种时刻,承担起「中间人」的角色,但同样有不少人对英国是否有能力担任这一角色提出质疑:最终有能力主导这场变革中建立规则的尝试的,或许只有中美两方。

在人工智能安全峰会期间,包括美国、中国以及欧盟在内的超过 25 个国家与会签署了《布莱切利宣言》,表示各国需要共同努力,建立共同的监督方法。

加州大学伯克利分校研究新兴军事技术的公共政策副教授安德鲁·雷迪表示,遏制人工智能武器风险的共同利益可能会克服中美之间的不信任。 他表示:“在追求降低风险方面,对抗性合作有着悠久的历史,这符合协议中两国的利益。”

只有推动监管跟得上技术进步,人类才有资格称之为 AI 的创造者。

相关阅读

RelatedReading猜你喜欢

Guessyoulike